Training the Archive

Fragen an ein Forschungsprojekt zur Entwicklung und zum Einsatz von KI in der Museumspraxis

Francis Hunger (Leipzig) und Barbara Büscher (Köln/Leipzig) im Gespräch

Training the Archive ist ein Kooperationsprojekt zwischen dem Ludwig Forum Aachen, dem Hartware MedienKunstVerein Dortmund sowie dem Visual Computing Institute der RWTH Aachen University. Gefördert wird das Projekt von 2020 bis 2023 im Rahmen des Fonds Digital der Kulturstiftung des Bundes mit 704.000 Euro. Die Projektvorstellung auf der Website der Kulturstiftung des Bundes[1] trägt den Untertitel „Entwicklung von Algorithmen zur Mustererkennung in Big Data Recherchen“. Festgehalten wird dort außerdem, dass die Entwicklung des Projekts transparent gemacht werden soll, indem Working Papers und Interviews veröffentlicht werden (siehe dazu den Blog[2]). Die beiden beteiligten Ausstellungshäuser haben unterschiedliche Voraussetzungen in Hinblick auf Sammlungstätigkeit und sie beschreiben ihren jeweiligen Beitrag zu den gemeinsamen Forschungen mit unterschiedlichen Akzentuierungen. Das Ludwig Forum verfügt über eine eigene Sammlung, der HMKV nicht, hat aber in der Vergangenheit bereits mehrfach in Ausstellungen zu Fragen digitaler Kunst und der besonderen Effekte digitaler Wissensgenerierung und -zugänge gearbeitet. Auf der Website des Ludwig Forums wird als zentrale Fragestellung formuliert:

„Damit verbunden ist die Forschungsfrage, ob KI Rechercheprozesse erlernen kann, so dass Muster, Zusammenhänge und Assoziationen erkennbar werden, die für den Menschen in dieser Form nicht ersichtlich sind.“[3]

In der Darstellung des Projektes auf der Website des HMKV wird diese Frage präzisiert: „Das Projekt widmet sich visuellen Archiven und der Frage, wie in diesen Sammlungen neue Zusammenhänge mittels ‚Machine Learning‘ hergestellt werden können.“ Weiter wird dort ausgeführt und damit auf den spezifisch diskursiven Part des HMKV hingewiesen:

„Ziel ist die forschungsbasierte Erstellung einer Software, die Kurator:innen und Künstler:innen neue Zugänge zu digitalisierten Bildsammlungen ermöglicht. Die Software soll Ähnlichkeiten und Unterschiede von Objekten und darüber hinaus gehende Zusammenhänge zwischen diesen in digitalen Sammlungen automatisiert visualisieren. (...) Ein weiteres Hauptaugenmerk liegt in der theoretischen und diskursiven Reflektion so genannter ‚Künstlicher Intelligenz‘.“[4] (Working Papers, Videointerviews)

Wir möchten das Projekt im Gespräch mit Francis Hunger, einem der beteiligten Forscher vorstellen, um den Recherche- und Entwicklungsprozess auch an dieser Stelle zugänglich zu machen und Fragen, die zu übergreifenden Aspekten eines algorithmischen Kuratierens führen, aufzugreifen. Die Fragen stellte Barbara Büscher. (BB)

(Bönisch, The Curator’s Machine. WP 1, 2021: 2)

BB: Als einer der ersten Punkte fällt auf, und ihr weist immer wieder darauf hin: Der Begriff ‚Künstliche Intelligenz‘ sollte thematisiert werden.

Francis Hunger: Der Begriff Künstliche Intelligenz stammt aus den 1960er Jahren, als Ingenieure und Wissenschaftler dachten, dass sie im Computer das menschliche Gehirn und menschliches Denken nachbilden könnten. Abgelöst von diesen historischen Ursprüngen wird der Begriff heute weiter verwendet, allerdings fälschlicherweise, so dass ich lieber von Mustererkennung oder noch zugespitzter von automatisierter Statistik spreche.

Der Begriff Künstliche ‚Intelligenz‘ verschleiert den hohen Anteil an menschlicher Arbeit der geleistet werden muss, um Daten aufzubereiten und Infrastrukturen zur Verfügung zu stellen, damit Musterkennung überhaupt funktioniert. Dahinter steht zudem eine Kritik an einer Auffassung, die das Denken als rein mechanistischen Akt konzipiert. So als ob einzelne Körperteile, wie das Gehirn, elektronischen Bauteilen entsprechen könnten. Auch dies ist eine historische Auffassung, die sich seit den 1960er Jahren durchzieht und die wissenschaftlich längst revidiert ist, den öffentlichen Diskurs aber weiterhin bestimmt. Die fälschliche Verwendung hat viel mit Hype zu tun, mit Fördermittelanträgen und akademischen Karrieren und mit Phantasmen, die sich auf die Fähigkeiten von Maschinen beziehen.

Bleiben wir zunächst noch bei Begrifflichkeiten: Was bedeuten Archiv und Sammlung für Euer Projekt?

FH: Archive und Sammlungen bestehen aus mehreren Schichten. Erstens, die Schicht der Sammlungsobjekte, die meistens in einer bestimmten Nomenklatur geordnet sind: in Karteikartenkästen, in Aufbewahrungsboxen, in Folianten oder in Regalmetern. Hier gibt es also bereits eine physikalische Ordnung, in welche die Dinge gebracht wurden. Diese durch Menschen installierte Ordnung des Wissens beruht auf Annahmen über die Welt und wie sich diese als Wissen organisieren lässt, was natürlich zu inhärent politischen Fragen führt, wie jener nach den Einschlüssen und Ausschlüssen einer Sammlung.

Die nächste Schicht berührt die Frage der Digitalisierung. Es werden Fotografien angefertigt und es werden durch Menschen Meta-Daten aufgeschrieben, welche die Sammlungsobjekte bezeichnen sollen. Das ist Datenerhebung im wortwörtlichen Sinne, die Daten werden aus der Realität heraus erhoben und in eine Struktur gebracht, also beispielsweise in eine Tabelle aufgenommen. Umgekehrt gesprochen: Voraussetzung dafür, dass etwas zu Daten werden kann, ist, dass es in eine Struktur gebracht werden kann. Und ebenso wie die Einordnung in Regalmetern und Aktenordnern, ist die Strukturierung in Datenbanken oder Excel-Tabellen eine wissensbildende Ordnung, die den Gegenständen Gewalt antut. Diese Schicht ist gleichzeitig auch eine Reduktion der Wirklichkeit der Sammlung. Die Wirklichkeit wird zu Daten reduziert. Hier ist bereits sehr viel menschliche Arbeit notwendig. Dabei werden jene Informationsanteile abgespalten, die in der Logik der Sammlung keine Rolle spielen. Dieses Abbild der Sammlung in Datenbanken ist mit der Sammlung selbst natürlich nicht identisch.

In Projekten zur Künstlichen Intelligenz gibt es dann noch eine weitere Schicht, welche mit mathematisch-statistischen Verfahren in der Lage ist, große Datenmengen zu filtern. Dafür wird häufig auch der Begriff Big Data verwendet.

Mit diesen drei Schichten abstrahieren wir die eigentlichen Sammlungsobjekte zunehmend und jede dieser Schichten fügt eine eigene Form der Ordnung hinzu, die Gegenstände werden somit durch ihre Dataisierung überformt.

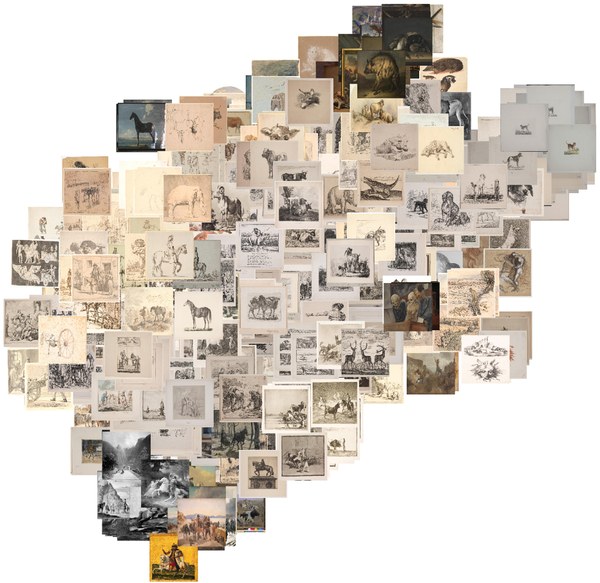

Abb. 1: Scatterplot eines Clusters mit Bildern unterschiedlicher Tierarten (Darstellung: Dominik Bönisch, Bilder: Statens Museum for Kunst, Kopenhagen, gemeinfrei)

Kommen wir nun zu Fragen, die die Verfahren betreffen, durch die Kunstsammlungen mit den Tools von Mustererkennung erschlossen werden sollen: In welchem Zustand muss das Bild / Objekt / der Datensatz sein, damit es diesem Prozess überhaupt unterzogen werden kann?

FH: Aus Gründen der Vereinfachung beziehe ich mich auf die Erkennung visueller Muster, lasse also Spracherkennung, Textanalyse und ähnliche Verfahren aus. Für die visuelle automatisierte Mustererkennung eignen sich am besten zweidimensionale Objekte, da das Visual Computing mit zweidimensionalen Bilddaten operiert. Zweidimensional bedeutet, es gibt eine Höhe und eine Breite, über die sich die Pixel eines Bildes erstrecken.

Bereits bei Skulpturen wird es problematisch, da hier beim Abfotografieren beispielsweise Beleuchtung und der Bildhintergrund zum Teil der zweidimensionalen Fotografie werden. KI-Verfahren können das per se erst einmal nicht unterscheiden. So hat Künstliche ‚Intelligenz‘ beispielsweise Probleme, Daten verschiedener Sammlungen die vor verschiedenfarbigen Hintergründen fotografiert wurden, sinnvoll zu ordnen, da sie sich nicht allein an den Objekten, sondern auch an den Bildhintergründen orientiert. Mehr noch: Diese Verfahren treffen gar keine konzeptuelle Unterscheidung, denn sie wissen überhaupt nicht, was das Konzept ‚Bildhintergrund‘ oder ‚Schattenwurf‘ aus menschlicher Sicht bedeutet, und dass es in der Bewertung vernachlässigbar ist.

Noch schwieriger wird es für ephemere Objekte, Projekte und Prozesse, die durch Visual Computing überhaupt nicht erfasst werden können. Es gibt einen Anteil an Objekten, der überhaupt nicht im Visuellen aufgeht, beispielsweise Gebrauchsobjekte. Also wie herum halte ich einen Löffel? Das weiß ich natürlich als Mensch, das habe ich mir als Kind kulturtechnisch angeeignet, aber die Maschine weiß es eben nicht, weil sie keine Suppe löffelt.

Es gibt Forschungsansätze, für die sich Training the Archive sehr interessiert, welche versuchen, bildgebende Verfahren zu kombinieren mit statistischen Verfahren für die Verarbeitung von Metadaten. Denn in den Metadaten lassen sich die Objekte in begrenztem Maße zusätzlich beschreiben und damit auch ephemere oder kontextuelle Aspekte adressieren. Doch auch hier hängen die Ergebnisse letztlich von den Ordnungen des Wissens ab, die bei der Erstellung der Metadaten eine Rolle spielen. Das wird beispielsweise sichtbar beim Zusammenführen mehrerer Museumssammlungen, die ihre jeweils eigenen Ordnungssysteme für Metadaten verwenden.

Zusammenfassend ergibt sich eine Abfolge der Bildmanipulationen, welche die Bilder in zunehmenden Maße operational machen. Dies geschieht in einem eigenständigen Schritt im Zuge der grundlegenden digitalen Erfassung einer Sammlung, die somit zur Bilddatensammlung wird:

5. Langzeitarchivierung und gegebenfalls Publikation der Sammlung

(Hunger, Why so many windows? WP 2, 2021: 4-5)

KI-Software muss offenbar trainiert werden – was heißt das und mit welchen Parametern findet das statt? Das scheint mir eine Basisfrage für alle, die sich nicht so gut auskennen: was bedeutet die Notwendigkeit des Trainings sowohl als Verfahren wie für die Zielsetzung? Geht es darum, bereits existierende Verfahren der gewichteten Netze mit neuen ‚Fähigkeiten‘ der Mustererkennung zu bestücken? Kannst Du das kurz zusammenfassen?

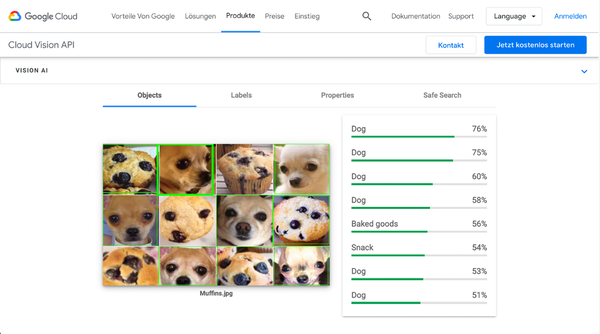

FH: Nein [lacht]. Ich muss das jetzt ganz schrecklich vereinfachen. Wir können uns die gewichteten Netze der künstlichen Intelligenz als parametrische Maschinen vorstellen. Das sind also Maschinen, die nicht über zehn oder hundert sondern über zehntausende Parameter verfügen. Diese Parameter werden nicht direkt vom Menschen eingestellt, und das ist das Neue dieser Verfahren. Vielmehr stellen in einem Prozess, der als Training bezeichnet wird, Algorithmen diese Parameter ein. Diese zehntausende Parameter, beziehungsweise Gewichte, erlauben es, wenn sie optimal eingestellt sind, noch ungesehene Bilder, die den Trainingsbildern ähneln, statistisch zuzuordnen. Also zu 70% ist dieses Bild ein ‚Hund‘ oder zu 88% eine ‚Katze‘, und so weiter.

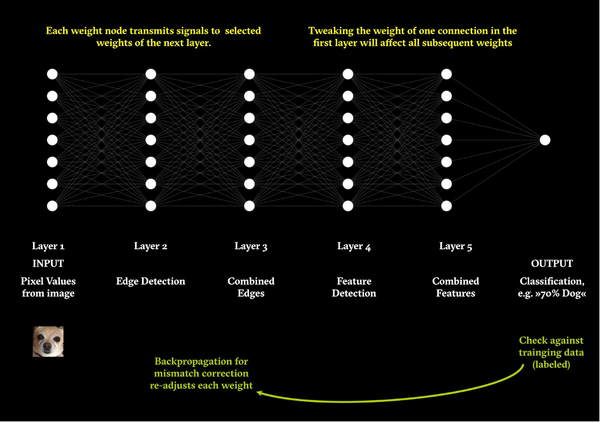

Abb 2: Funktionsschema Gewichtetes Netzwerk zur Bilderkennung

(Grafik: Francis Hunger)

Die Algorithmen, also Rechenanweisungen beziehungsweise mathematisch-statistische Funktionen, überprüfen, welche Daten in ein gewichtetes Netz eingehen (Input) und zu welchen Ergebnissen sie führen (Output). Die Algorithmen gehen so vor, dass sie mehrere Durchläufe machen und bei jedem Durchlauf mit leicht veränderten Parametern die Gewichte verändern. Dieser Prozess ist von den Ergebnissen abhängig (Output) und, da er zurück in das gewichtete Netz wirkt, heißt er Backpropagation.

Unter Training wird nun das Folgende verstanden: Ein Datensatz, der bereits mit einer inhaltlichen Beschriftung, einem Label, versehen ist, also mit Bedeutungszuschreibungen - und das ist eine Arbeit, die durch Menschen erledigt wurde und nur durch sie erledigt werden kann - also dieser Datensatz wird Stück für Stück durch ein gewichtetes Netz durchgeschleust, wobei nach und nach die Gewichte dieses Netzes eingestellt werden. Da der Algorithmus bereits über Label für dieses Bild verfügt, kann er am Ende im Output überprüfen, ob ein Bild richtig erkannt wurde. Ist dies nicht der Fall, beginnt automatisch der Prozess der Backpropagation, d.h. die Gewichte im Netz werden so geändert bis das Trainingsbild maximal gut erkannt wird. Nach diesem relativ langwierigen Prozess spricht man von vortrainierten Netzen, die dann auf andere, noch unbekannte, Datensätze angewendet werden können. Also beispielsweise auf Bildsammlungen, die über keine Labels, also Bedeutungszuschreibungen, verfügen. Es wird deutlich, dass hier der Begriff Intelligenz unangebracht ist, da Intelligenz nur dort stattfindet, wo Menschen konkret sich Daten ansehen und mit Beschreibungen des Bildinhaltes versehen. Von maschineller Seite erfolgen lediglich mathematisch-statistische Berechnungen.

Abb. 3: Bewertung des ‚Chihuahua or Muffins‘-Memes von Karen Zack durch

Google Cloud Vision (Screenshot, 2021).

Wie ist durch diese Parameter der Erkenntnisgewinn determiniert?

Ich ärgere mich häufig darüber, wenn in Bezug auf sogenannte Künstliche ‚Intelligenz‘ so oft die Rede von Algorithmen ist, denn die Algorithmen dienen hauptsächlich der Optimierung von Rechenprozessen. Sie machen also komplexe Rechenprozesse schneller und effektiver, und auf dieser Optimierung beruht der Sprung den wir in den letzten Jahren im Bereich der Künstlichen ‚Intelligenz‘ erleben.

Wichtiger jedoch ist die Frage der Daten, denn in den Zuschreibungen, welche durch Menschen zu bestimmten Datenobjekten gemacht werden, liegt viel politisches Potenzial. Nicht die Algorithmen sind’s, es sind die Daten.

Als Beispiel fällt mir ein, wie Bilder in der für das Training verwendeten Bildsammlung ImageNet der Kategorie ‚Paris‘ zugeordnet sind. Dort finden sich neben prototypischen Stadtansichten von Paris auch zahlreiche Bilder von Paris Hilton. Die Arbeiter*innen, die diese Bilder gelabelt haben, wurden als Clickworker per Amazon Turk angestellt. Aufgrund der schlechten Bezahlung, das sind wenige Cent pro Bild, bleibt für jedes Bild nur wenig Zeit, und so ist es kein Wunder, wenn diese Zuschreibungen zu Stande kommen und aus Paris dann Paris Hilton wird. Das ist dann in den Datensatz eingeschrieben.

Ein anderes Problem liegt aber auch in den Kategorien, welche als Label überhaupt zur Verfügung stehen. Ich untersuche zum Beispiel gerade kunsthistorische Sammlungen von deutschen Universitäten und Museen, die noch immer nicht dekolonisiert sind. Da finden sich dann umstandslos Kategorien wie ‚Neger‘ oder ‚Mohr‘. Andere Labels sind abwertende Beschreibungen wie ‚Schlampe‘ die als Label für Bilder mit nackten Frauenkörpern zugeschrieben wurden.

Um auf die Frage zurückzukommen: Der Erkenntnisgewinn bezieht sich größtenteils auf die Ordnungssysteme, mit denen die gewichteten Netze trainiert und die Trainingsdatensätze gelabelt werden.

Zentral scheint mir die Frage zu sein: Was soll/wird der Mehrwert sein? Sollen durch formalisierte Mustererkennung überraschende, den Kanon überschreitende, kunstwissenschaftliche Kriterien überschreibende Zusammenhänge sichtbar werden?

Training the Archive hat sich aufgrund der hier vorgestellten Analyse entschieden, die Klassifikationskomponente gewichteter Netze nicht zu verwenden, sondern sich stärker auf Ähnlichkeiten der Bilddaten zu konzentrieren, die aus den vorhergehenden Schichten gewichteter Netze gezogen werden. Auf Ähnlichkeiten beziehen wir uns mit dem Softwareprototypen der Curator’s Machine. Die Idee ist, ein Interface zu schaffen, welches auf die persönlichen Interessen und Schwerpunkte von Kurator:innen in Echtzeit trainiert werden kann. Dieses Verfahren ermöglicht ein exploratives Erkunden großer Sammlungen, so dass Kurator:innen zu einem bestimmten, von Ihnen ausgewählten, Bildkonvolut weitere passende Bilder angezeigt bekommen. Wir gehen dabei davon aus, dass ein Big-Data-Ansatz allenfalls unterstützend in großen Sammlungen ist und keinesfalls die kuratorischen Entscheidungen voll-automatisiert.

Überraschend sind dann Überschneidungen, die sich aus den Datensätzen ergeben oder daraus, wie die jeweils eingesetzten gewichteten Netze trainiert wurden. So zeigten beispielsweise die Künstler und Medientheoretiker Gabriel Pereira und Bruno Moreschi für die Sammlung des van Abbe Museum Amsterdam auf, dass modernistische Bilder von Mondrian durch vortrainierte Netze als ‚Fenster‘ oder ‚Fernseher‘ identifiziert werden. Mit diesem maschinell-statistischen Blick lassen sich kunsthistorische Beschreibungsebenen gegen den Strich bürsten und neu lesen. Der andere Mehrwert jenseits dieser Zufallsfunde liegt in der Möglichkeit, große Bildsammlungen mit zehntausenden Bildobjekten nicht allein anhand von Metadaten, wie in klassischen Suchmaschinen, sondern anhand von Bildähnlichkeiten durchsuchen zu können. Es ist also gewissermaßen eine Suche nach Kunstwerken, die wir in der Sammlung noch nicht kennen und Begriffen, die wir nicht eins zu eins in einer herkömmlichen Datenbank finden. Wir sind hier auch Teil eines größeren Forschungsprozesses der Digital Humanities, welche die Potentiale der Digitalisierung erkunden und kritisch hinterfragen.

Ihr habt entschieden, den Forschungsprozess in gewissen Formen transparent für eine interessierte Öffentlichkeit zu machen,

a) indem ihr laufend Working Papers publiziert, die Eure eigenen Untersuchungen, Überlegungen und Lektüreprozesse als Zwischenstände publizieren: wieso und an richten sie sich?

Wir sind ein sehr kleines Team, daher ist der Austausch mit ähnlich gelagerten Projekten äußerst wichtig. Training the Archive, initiiert durch Dominik Bönisch am Ludwig Forum Aachen kooperiert mit dem Hartware MedienKunstVerein, das heißt Inke Arns und mir. Das sind im Kern nur drei Forschende, zu denen dann noch die Beteiligten am Visual Computing Institute der RWTH Aachen kommen, die in die Programmierung involviert sind.

Im Zuge der Working Papers sind wir im Kontakt mit anderen Forschenden, die an ähnlichen Problemen arbeiten. Außerdem haben wir uns für ein Forschungsdesign entschieden, bei dem wir einerseits selbst einen Softwareprototypen entwickeln und gleichzeitig einen Prozess der Kritik einbinden, der die Entwicklung selbst-reflektiert. Die Working Papers sind somit in gleichem Maße nach außen wie nach innen gerichtet. Ich denke nicht, dass wir für alle in den Working Papers aufgeworfenen Probleme Lösungen finden werden, sondern ich hoffe, dass ähnlich gelagerte Forschungsprojekte von den Überlegungen profitieren.

b) indem ihr Videointerviews mit Expert:innen aus diesem Forschungsfeld führt und sie online zugänglich gemacht. Mit wem sprichst und wonach kuratierst Du dieses Programm?

Bisher wurden die Künstler:innen Elisa Giardina Papa und Adam Harvey, die Kuratorin Magda Tyżlik-Carver, die Medienhistorikerin Mar Hicks, der Medienphilosoph Matteo Pasquinelli, die Soziologen Ulises Mejias und Nick Couldry sowie der bereits erwähnte Gabriel Pereira befragt.[5] Das Hauptkriterium war es, mit Expert:innen zu sprechen, die eine spezifische Haltung zu Künstlicher ‚Intelligenz‘ einnehmen und deren Einschätzung auf einem Verständnis der technischen Grundlagen Künstlicher ‚Intelligenz‘ beruhen und nicht allein auf Allgemeinplätzen über ‚Algorithmen‘, die leider weit verbreitet sind.

Die Videointerviews bieten für Training the Archive eine Möglichkeit, mit Expert:innen in Verbindung zu treten, welche bereits seit längerem eine Kritik der Künstlichen ‚Intelligenz‘ und der damit verbundenen Bildproduktion entfalten. Dadurch aktivieren wir kritisches Wissen jenseits des Hypes und machen es einer Öffentlichkeit zugänglich.

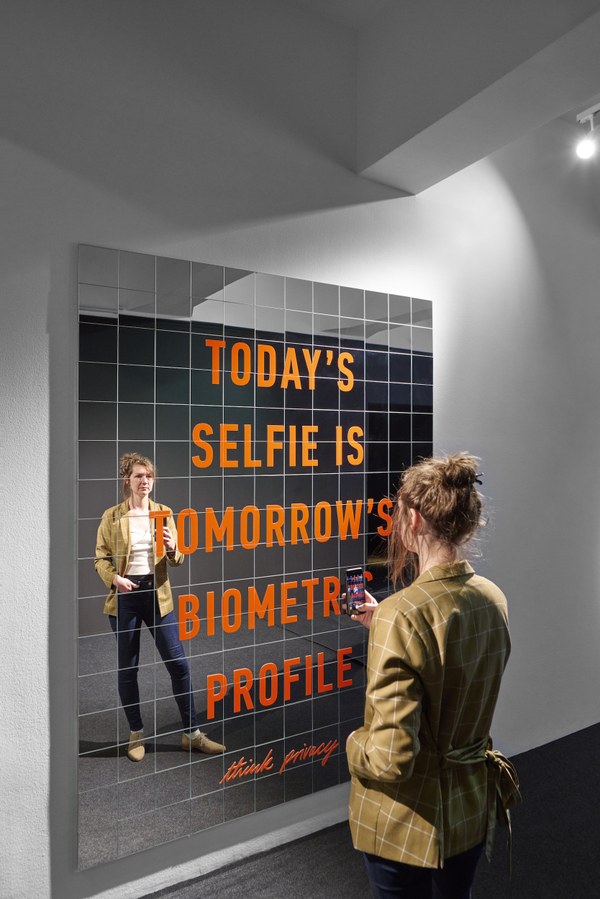

c) indem ihr zu dritt (Inke Arns, Francis Hunger, Marie Lechner) soeben eine Ausstellung im HMKV kuratiert und eröffnet habt, die unter dem Titel House of Mirrors: Künstliche Intelligenz als Phantasma künstlerische Positionen präsentiert, die sich detailreich, informiert und spielerisch mit Implikationen von KI und deren Anwendung auseinandersetzt. Kannst Du dies als ‚Begleitprogramm‘ zum Forschungsprojekt erläutern?

Es ist eher ein Parallelprogramm, da die Ausstellung formal nicht an Training die Archive angegliedert ist, sondern eine Eigenentwicklung des HMKV ist. Natürlich: Durch die personellen Überschneidungen, und vor allem durch das angereicherte Wissen, dass wir innerhalb von Training die Archive produziert haben, ergab sich quasi eine Notwendigkeit, im Ausstellungsraum des HMKV auch mit einer Ausstellung zu reagieren. Doch während Training The Archive sich vor allem einem Softwareprototypen verschrieben hat, setzt die Ausstellung House of Mirrors – Künstliche Intelligenz als Phantasma einen anderen Schwerpunkt. Hier geht es eher um die Phantasmen, die Vorstellungen, die sich in unserer Gesellschaft mit dem Begriff der Künstlichen ‚Intelligenz‘ verbinden, und die häufig verdeckte Fantasien des Beherrschtwerdens oder auch der Vollautomatisierung umfassen. Ich bin natürlich sehr glücklich darüber, an diesen beiden, einander ergänzenden Projekten beteiligt zu sein und danke meinen Kolleg:innen Inke Arns und Dominik Bönisch, die das ermöglicht haben.

Danke vielmals für die Erläuterungen. Wir sind gespannt auf Eure weiteren Ergebnisse und Publikationen aus dem Projekt.

Abb. 4: Anna Ridler: Laws of ordered Form (Ausstellungsansicht,

Hartware MedienKunstVerein, Dortmund 2022, Foto: Mareike Tocha)

Abb. 5: Adam Harvey: Today's selfie is tomorrow's biometric profile (Ausstellungsansicht, Hartware MedienKunstVerein, Dortmund 2022, Foto: Mareike Tocha)